La Promessa Tradita: Quando l’Intelligenza Artificiale Riflette i Nostri Pregiudizi

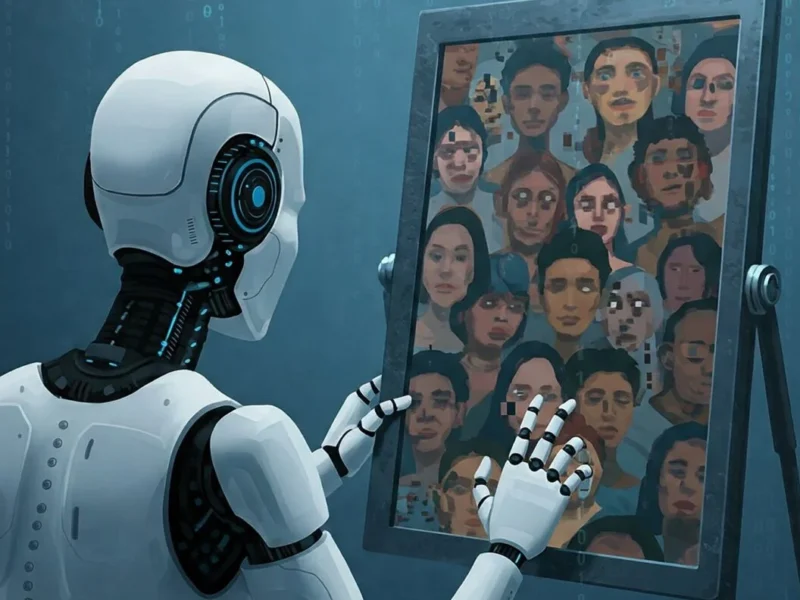

L’intelligenza artificiale (IA) è stata spesso celebrata come una forza rivoluzionaria, capace di liberarci dai pregiudizi e dalle limitazioni umane. L’idea che gli algoritmi, fredde equazioni matematiche, potessero prendere decisioni in modo più razionale e obiettivo rispetto a noi, era allettante.

Ma la realtà, purtroppo, si sta rivelando più complessa. L’IA, lungi dall’essere una panacea, può diventare uno specchio distorto delle nostre stesse imperfezioni, riflettendo e amplificando i bias che ancora permeano la nostra società.

Il Vizio Originale: Come i Dati Insegnano Pregiudizio alle Macchine

L’Apprendimento Automatico e i Suoi Limiti

Per comprendere questo fenomeno, dobbiamo partire dal modo in cui le macchine “imparano”. Gli algoritmi non nascono con un’innata capacità di giudizio; acquisiscono conoscenze e abilità analizzando enormi quantità di dati. È qui che il problema ha origine.

Se i dati che forniamo all’IA riflettono disuguaglianze storiche, stereotipi culturali o pregiudizi impliciti, è inevitabile che anche le decisioni dell’IA ne saranno influenzate. Questo meccanismo è alla base del cosiddetto bias algoritmico.

Esempi Concreti di Discriminazione Algoritmica

Nel recruiting automatizzato: Un sistema di IA per la selezione del personale, addestrato su dati che mostrano una predominanza di uomini in posizioni di leadership, potrebbe imparare a considerare “ideale” il profilo maschile, penalizzando involontariamente le candidate donne. Secondo uno studio pubblicato su Harvard Business Review, questi sistemi possono perpetuare discriminazioni di genere anche quando il genere non è esplicitamente incluso nei parametri di valutazione.

Nel riconoscimento facciale: Un software istruito principalmente su immagini di persone con la pelle chiara potrebbe avere difficoltà a identificare accuratamente i volti di persone con la pelle più scura. La ricerca condotta da Joy Buolamwini al MIT ha dimostrato che alcuni sistemi commerciali hanno tassi di errore fino al 34% più alti per le donne con la pelle scura.

Nella giustizia predittiva: Come abbiamo analizzato nel nostro articolo su Giustizia Digitale, algoritmi utilizzati per valutare il rischio di recidiva mostrano bias sistematici contro le minoranze etniche.

Questi non sono scenari ipotetici, ma esempi concreti di come l’IA, anche senza un intento malevolo, può perpetuare la discriminazione.

Le Molte Facce del Bias Algoritmico

Tipologie di Bias nell’IA

Il problema dell’AI bias è sfaccettato e si manifesta in modi diversi:

Bias storico: Quando i dati di training riflettono ingiustizie del passato Bias di rappresentazione: Quando alcuni gruppi sono sottorappresentati nei dataset Bias di conferma: Quando gli algoritmi rafforzano pregiudizi esistenti Bias di misurazione: Quando le metriche utilizzate favoriscono determinati gruppi

Oltre i Dati: Il Ruolo Umano nel Bias

Non si tratta solo di una questione di dati “sporchi”. Anche la progettazione degli algoritmi, le scelte di sviluppo e le modalità di utilizzo possono introdurre distorsioni, come evidenziato nella nostra analisi dell’etica dell’intelligenza artificiale.

A volte, i bias sono evidenti, come quando un sistema esclude direttamente un gruppo di persone. Ma spesso, i bias sono più sottili e difficili da individuare, annidandosi nelle metriche che scegliamo di misurare, nei parametri che impostiamo, o persino nel modo in cui interpretiamo i risultati.

L’Impatto Sociale del Bias Algoritmico

Conseguenze Concrete nella Società

L’AI bias non è solo un problema teorico. Ha conseguenze tangibili che influenzano la vita di milioni di persone:

- Discriminazione nell’accesso al credito: Algoritmi bancari che penalizzano sistematicamente alcune comunità

- Ineguaglianze nell’assistenza sanitaria: Sistemi di IA che sottovalutano i bisogni medici di determinati gruppi demografici

- Perpetuazione delle disuguaglianze educative: Come esplorato nel nostro articolo sull’IA nell’istruzione

Il Circolo Vizioso della Discriminazione

Il bias algoritmico può creare un circolo vizioso: le decisioni discriminatorie dell’IA influenzano la realtà, generando nuovi dati distorti che a loro volta alimentano algoritmi ancora più discriminatori.

Verso un’IA Giusta: Strategie e Soluzioni

Approcci Tecnici per Mitigare il Bias

Diversificazione dei dataset: Garantire rappresentazione equa di tutti i gruppi Algoritmi di fairness: Sviluppo di modelli che ottimizzano esplicitamente per l’equità Auditing algoritmico: Test sistematici per identificare bias nascosti Interpretabilità: Come discusso nel nostro articolo sui bias algoritmici, è essenziale rendere gli algoritmi spiegabili

Il Ruolo della Governance e Regolamentazione

L’Unione Europea ha proposto l’AI Act, la prima regolamentazione completa sull’IA al mondo, che include specifiche disposizioni contro la discriminazione algoritmica.

Un Nuovo Patto tra Uomo e Macchina

Responsabilità Condivisa

La lotta contro l’AI bias richiede un impegno collettivo che coinvolge:

- Sviluppatori: Implementing fairness by design

- Aziende: Audit regolari e trasparenza

- Legislatori: Normative appropriate

- Società civile: Monitoraggio e advocacy

Principi Guida per un’IA Etica

Come abbiamo approfondito nella nostra guida all’etica dell’IA, i principi fondamentali includono:

- Trasparenza e spiegabilità

- Responsabilità umana

- Equità e non discriminazione

- Privacy e dignità umana

FAQ: Domande Frequenti sul Bias Algoritmico

Cos’è esattamente il bias algoritmico? Il bias algoritmico è la tendenza sistematica di un algoritmo a produrre risultati discriminatori o ingiusti verso determinati gruppi di persone, spesso riflettendo pregiudizi presenti nei dati di training o nelle decisioni di progettazione.

Come posso sapere se un algoritmo è biased? Alcuni segnali includono: disparità nei risultati tra diversi gruppi demografici, mancanza di trasparenza sui criteri decisionali, e performance significativamente diverse per categorie diverse di utenti.

È possibile eliminare completamente il bias dall’IA? Eliminare completamente ogni forma di bias è estremamente difficile, ma è possibile ridurlo significativamente attraverso design consapevole, diversificazione dei dati, test rigorosi e monitoraggio continuo.

Chi è responsabile quando un algoritmo discrimina? La responsabilità è spesso condivisa tra sviluppatori, aziende che implementano il sistema, e istituzioni che lo utilizzano. La chiara attribuzione di responsabilità è uno dei temi centrali della regolamentazione emergente.

Come influisce il bias algoritmico sulla vita quotidiana? Il bias può influenzare opportunità di lavoro, accesso al credito, diagnosi mediche, raccomandazioni educative, e molti altri aspetti della vita quotidiana, spesso in modi invisibili agli utenti.

Conclusione: Il Futuro dell’IA Dipende dalle Nostre Scelte

L’intelligenza artificiale ha il potenziale per migliorare radicalmente le nostre vite, ma questo potenziale non si realizzerà automaticamente. Come evidenziato nelle nostre riflessioni su sorveglianza e IA, dobbiamo essere vigili sui rischi mentre lavoriamo per massimizzare i benefici.

Dobbiamo stringere un nuovo patto tra uomo e macchina, basato sulla trasparenza, sulla responsabilità e sulla consapevolezza. Un patto in cui riconosciamo i limiti dell’IA come strumento e mettiamo sempre al centro i valori umani fondamentali: l’equità, la giustizia e la dignità.

Il futuro dell’IA giusta dipende dalle scelte che facciamo oggi. Ogni algoritmo progettato, ogni dataset curato, ogni decisione di implementazione è un’opportunità per costruire un mondo più equo o per perpetuare le ingiustizie esistenti.

La sfida è grande, ma così è l’opportunità di creare tecnologie che servano veramente tutta l’umanità.