Giustizia automatizzata: efficienza o illusione?

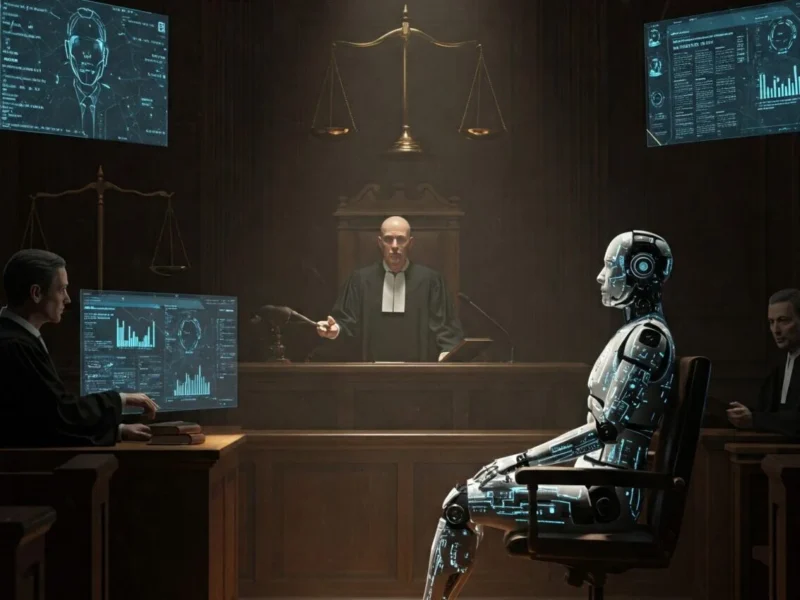

L’idea di un sistema giudiziario più efficiente, neutrale e oggettivo, affidato alla logica matematica di un’intelligenza artificiale, ha un fascino indubbio. Immaginiamo tribunali capaci di analizzare enormi quantità di dati in pochi secondi, riconoscere pattern invisibili agli esseri umani e produrre decisioni rapide, coerenti, magari libere da pregiudizi emotivi.

Un sistema in cui la bilancia della giustizia penda, finalmente, verso una vera imparzialità.

Ma è davvero questa la promessa dell’IA applicata al diritto? Oppure rischiamo di confondere efficienza con equità, e di introdurre nuove forme di ingiustizia, invisibili perché mascherate da apparente oggettività?

I vantaggi dell’intelligenza artificiale nel campo legale

L’entusiasmo è comprensibile. I sistemi predittivi basati su IA offrono molti potenziali vantaggi:

- Valutazione del rischio di recidiva

- Analisi giurisprudenziale su larga scala

- Redazione assistita di documenti legali

- Accelerazione delle procedure e uniformità decisionale

In teoria, tutto ciò potrebbe portare a un sistema giudiziario più rapido, coerente ed economico. L’IA può scoprire connessioni nei dati che sfuggono anche ai giuristi più esperti.

Bias algoritmico: il cuore oscuro della giustizia predittiva

Tuttavia, dietro questa visione si nascondono ombre inquietanti. I sistemi IA funzionano solo grazie ai dati su cui vengono addestrati. E se questi dati sono il riflesso di disuguaglianze, pratiche discriminatorie o pregiudizi storici, l’algoritmo non farà che replicarli.

Questo fenomeno si chiama bias algoritmico. Non è un bug, ma una caratteristica intrinseca di ogni IA mal nutrita.

Esempio: se i dati storici sui reati riflettono controlli più severi su determinate etnie, l’algoritmo potrebbe classificare quegli stessi gruppi come “più a rischio” – anche se la realtà è più complessa.

👉 L’IA Ingiusta: Bias e Discriminazione nei Dati

👉 AI Now 2018 Report – Fairness in Criminal Justice

Il pericolo dell’algoritmo inumano

Il rischio più grande non è solo l’errore statistico. È la perdita di umanità nel giudizio.

Un algoritmo non conosce il contesto sociale, la storia personale, le circostanze attenuanti. Non può provare empatia, né cogliere sfumature morali. Ridurre le persone a variabili numeriche significa trasformare il giudizio in calcolo.

Un sistema del genere, per quanto efficiente, rischia di essere profondamente inumano.

👉 IA e Sorveglianza: Chi controlla chi?

Come rendere l’IA compatibile con la giustizia

Non si tratta di demonizzare la tecnologia. L’IA può davvero migliorare il sistema giudiziario, ma solo se:

- i dati sono puliti, equi e rappresentativi

- gli algoritmi sono trasparenti e spiegabili

- c’è sempre una supervisione umana attiva

- esistono meccanismi per correggere errori e contestare decisioni

Serve una governance etica in grado di unire competenze legali, tecnologiche e umanistiche.

👉 Etica dell’Intelligenza Artificiale: Perché ci riguarda tutti

👉 FRA – Artificial Intelligence and Fundamental Rights

Una sfida multidisciplinare, umana e politica

Il futuro della giustizia digitale richiede un confronto aperto tra:

- sviluppatori e informatici

- magistrati, avvocati, giuristi

- filosofi, etici, sociologi

- cittadini e associazioni per i diritti

L’obiettivo non è solo integrare la tecnologia. È costruire un sistema più equo, trasparente e umano, in cui l’IA sia uno strumento al servizio della giustizia — non un meccanismo che ne amplifica le debolezze.

👉 IA e Democrazia: Algoritmi e Processi Elettorali

La vera domanda

La vera domanda non è: “Possiamo usare l’IA nei tribunali?”

Ma: “Come possiamo farlo senza perdere la nostra idea di giustizia?”